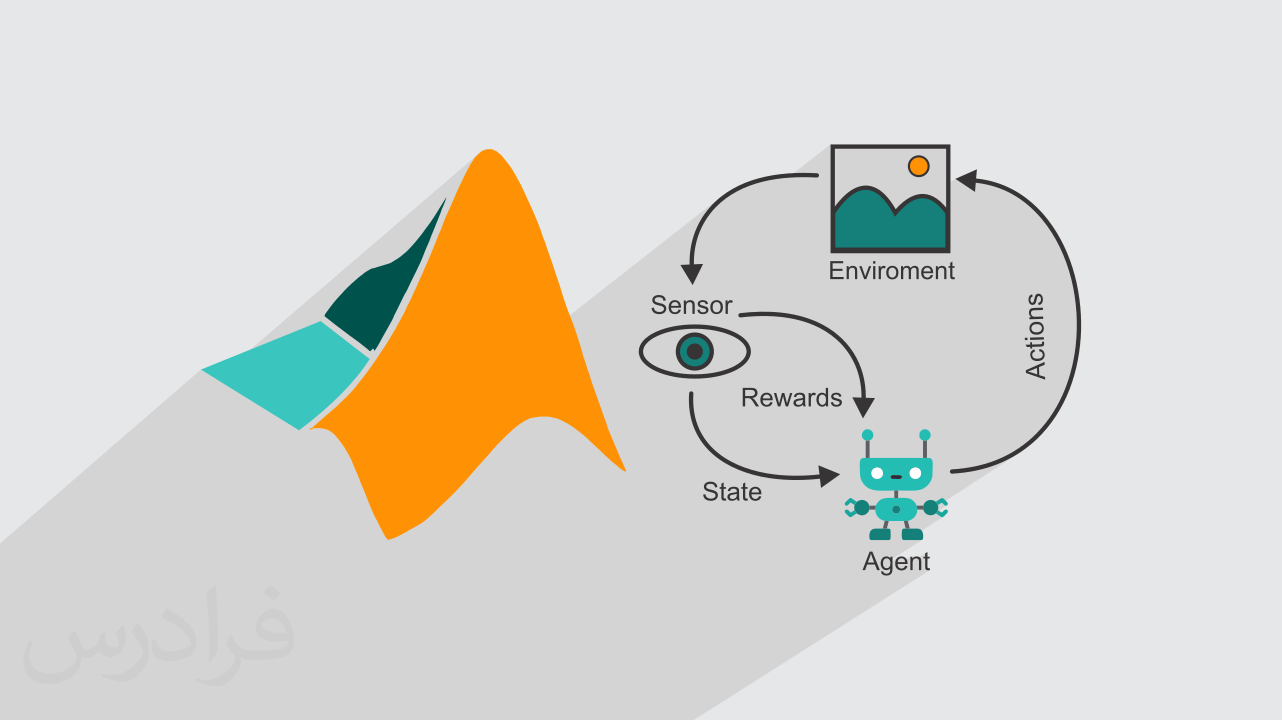

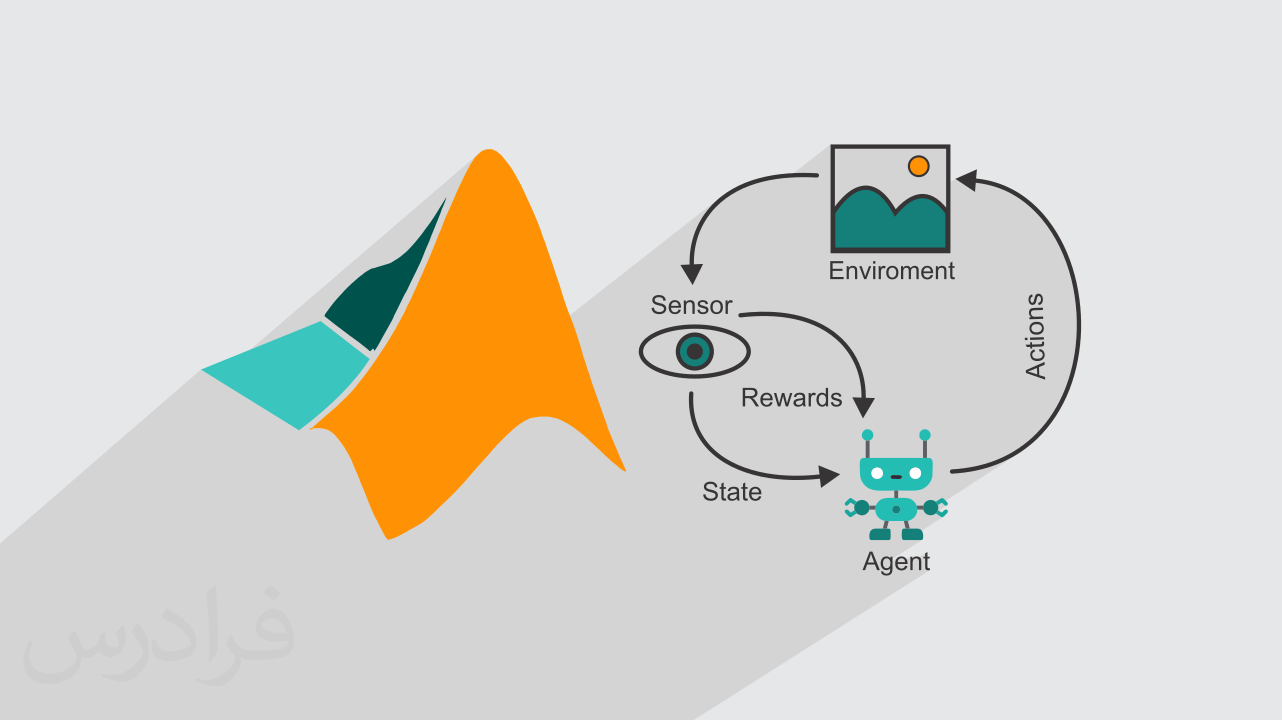

آموزش یادگیری تقویتی با متلب MATLAB

در یادگیری تقویتی عامل از طریق تعامل با محیط تجربه کسب میکند و یاد میگیرد کارهایی را انجام دهد که منجر به دریافت بیشترین پاداش در آینده شود. یادگیری تقویتی در حقیقت روش محاسباتی برای یادگیری از طریق تجربه و تعامل با محیط و همواره در تلاش برای ماکزیمم کردن پاداشها در بلندمدت است. به بیان دیگر، یادگیری تقویتی یک نگاشت از موقعیت به عمل است، یعنی نشان میدهد در هر موقعیت یا حالتی چه عملی باید انجام شود تا به هدف برسیم. در این آموزش به بخش مقدماتی یادگیری تقویتی میپردازیم و شالوده این الگوریتم را یاد میگیریم.

- درس یکم: مفاهیم مقدماتی یادگیری تقویتی - بخش یکم

- انواع الگوریتمهای یادگیری ماشین

- یادگیری نظارتشده

- یادگیری غیر نظارتی

- درس دوم: مفاهیم مقدماتی یادگیری تقویتی - بخش دوم

- یادگیری تقویتی

- اجزای یادگیری تقویتی

- محیط

- عامل

- عمل و سیاست

- پاداش

- Exploration و Exploitation

- درس سوم: مساله Multi-Armed Bandit - بخش یکم

- مساله Multi-Armed Bandit

- سیاستهای Greedy و ε-greedy

- پیادهسازی افزایشی تابع ارزش

- کدنویسی سیاستهای Greedy و ε-greedy

- درس چهارم: مساله Multi-Armed Bandit - بخش دوم

- مسائل غیر ایستا

- الگوریتم Constant-Alpha

- مقادیر اولیه خوشبینانه

- درس پنجم: مساله Multi-Armed Bandit - بخش سوم

- الگوریتم باند بالای اطمینان (UCB)

- کدنویسی UCB در متلب (MATLAB)

- الگوریتم گرادیان تصادفی صعودی (SGA) برای حل مساله Bandit

- درس ششم: مساله Multi-Armed Bandit - بخش چهارم

- کدنویسی SGA در متلب

- مقایسه روشها

- درش هفتم: فرایندهای تصمیمگیری مارکوف محدود (FMDP) - بخش یکم

- فرایندهای تصمیمگیری مارکوف (MDP)

- اجزای MDP

- دینامیک MDP

- درس هشتم: فرایندهای تصمیمگیری مارکوف محدود (FMDP) - بخش دوم

- توابع احتمال MDP

- حل چند مثال از MDP

- بازگشت (Return) و دوره (Episode)

- حل چند مثال از بازگشت

- درس نهم: فرایندهای تصمیمگیری مارکوف محدود (FMDP) - بخش سوم

- سیاست و تابع ارزش

- ارزش حالت

- ارزش حالت - عمل

- معادلات بلمن برای ارزشها

- حل معادلات بلمن برای مساله Grid World

- حل مثال از معادلات بلمن

- سیاست و توابع ارزش بهینه

- معادلات بهینگی بلمن برای ارزشها

- حل مثال از معادلات بهینگی بلمن

- حل مثال از تعیین سیاست بهینه

- درس دهم: برنامهریزی پویا - بخش یکم

- برنامهریزی پویا (DP)

- ارزیابی سیاست (Policy Evaluation)

- مقدمهای بر روش ژاکوبی (Jacobi Method) و گاوس-سایدل (Gauss–Seidel)

- کدنویسی محیط بازی در متلب (MATLAB)

- کدنویسی ارزیابی سیاست در متلب

- درس یازدهم: برنامهریزی پویا - بخش دوم

- بهبود سیاست (Policy Improvement)

- کدنویسی بهبود سیاست در متلب

- کدنویسی تولید یک Episode از بازی با سیاست مشخص

- تکرار سیاست (Policy Iteration)

- درس دوازدهم: برنامهریزی پویا - بخش سوم

- کدنویسی تکرار سیاست در متلب

- تکرار ارزش (Value Iteration)

- کدنویسی تکرار ارزش در متلب

- تکرار سیاست تعمیمیافته (Generalized Policy Iteration)

- درس سیزدهم: روشهای مونتکارلو - بخش یکم

- مقدمهای بر روش مونت کارلو

- تخمین ارزش حالتها با MC

- الگوریتمهای First Visit و Every Visit

- کدنویسی تخمین ارزش حالتها با MC در متلب

- تخمین MC برای محیطهای غیر ایستا

- تخمین ارزش حالت-عملها با MC

- درس چهاردهم: روشهای مونتکارلو - بخش دوم

- الگوریتم Exploring Starts

- کدنویسی تخمین ارزش حالت-عملها با MC در متلب

- Control On-policy Monte Carlo

- کدنویسی الگوریتم On-policy در متلب

- قضیه نمونهبرداری اعتباری

- حل مثال از قضیه نمونهبرداری اعتباری

- Off-Policy Monte Carlo Control

- درس پانزدهم: یادگیری با تفاضل مکانی (Temporal Difference)

- مقایسه روشهای DP, MC و TD

- الگوریتم پیشبینی TD(0)

- کدنویسی TD(0) در متلب

- مزایای روشهای پیشبینی TD

- الگوریتم SARSA - کنترل On-Policy

- الگوریتم Q-Learning - کنترل Off-Policy

- کدنویسی الگوریتم Q-Learning در متلب

- تست الگوریتم Q-Learning در محیط جدید

منبع:

فرادرس